|

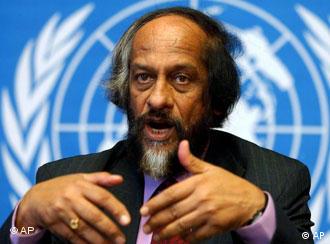

Una visión estadística de la teoría del calentamiento global antropogénico. |

Si el aumento de la temperatura es consistente con o es evidencia de calentamiento global, ¿qué teoría es consistente con o es evidencia de temperaturas en descenso? ¿Acaso también el calentamiento global?

Debemos realizar esta complicada pregunta porque se acaba de informar que la temperatura global promedio de este año está en camino de ser la más fría en ocho años. En otras palabras, la temperatura ha caído, y lo ha estado haciendo por un par de años.

Entonces, ¿estas temperaturas en descenso significan que el calentamiento global se ha detenido, o que es falso?

“Absolutamente no”, dijo el Dr. Peter Stott, gerente de comprensión y atribución del cambio climático en el Centro Hadley de Met Office.

También sabemos de “un equipo de científicos del clima de la universidad de Kiel” que predijo que las variaciones naturales enmascararían el calentamiento de 0,3º predicho por el Panel Intergubernamental para el Cambio Climático (IPCC por sus siglas en inglés, = Intergovernment Panel on Climate Change) a lo largo de la próxima década. Los científicos dijeron que las temperaturas globales permanecerían constantes hasta 2015, pero que entonces comenzarían a acelerarse.

Esto será complicado, y no hay muchas formas de lograr que este asunto sea fácil de comprender, de modo que sujétense.

Deberemos explorar qué significa que una evidencia sea “consistente con” o “inconsistente con” una teoría, qué significa para una teoría ser correcta o incorrecta, y qué significa ser probablemente correcta o probablemente incorrecta.

Consistencia

Supongamos, entonces, que la teoría del calentamiento global antropogénico sostiene, entre otras cosas, que la temperatura ciertamente subirá año tras año. Pero la temperatura no ascendió, y de hecho descendió. Esta evidencia es inconsistente con la teoría, de modo que la teoría es falsa porque realizó una predicción que decía que las temperaturas en descenso eran imposibles. Si se prefiere, podríamos decir que esta teoría ha sido falsada (un término de Popper de muy poca utilidad; un tema a explorar de lleno otro día).

Se ha probado que nuestra teoría de cartón es falsa. Puede entonces ser arrojada a la basura, olvidada, ignorada. ¡Los escépticos pueden regocijarse! De hecho, cualquier teoría que haga una predicción que diga “X ocurrirá seguramente (en tales y tales circunstancias), y luego que ocurra “no X”, habrá sido falsada, lo que en lenguaje común significará que está equivocada (“no X” significa “cualquier circunstancia que ciertamente sea “no X”).

Sin embargo, la teoría actual del calentamiento global antropogénico (CGA) no hace ninguna afirmación del tipo “la temperatura seguramente ascenderá año a año”. En cambio, afirma algo así como que “la temperatura probablemente subirá año a año”. Podemos llegar más lejos y decir que casi todas las afirmaciones de la teoría son declaraciones de este tipo, es decir, declaraciones de probabilidad.

Existe solamente una afirmación de certeza en la teoría CGA y es que “la humanidad influye en el clima”. Esta aseveración es trivialmente cierta. Es imposible que la humanidad no influya en el clima. Cada acción que se realice, cada vez que se respira, se modifica el clima. De hecho, podemos ampliar la afirmación y decir que “todos los organismos influyen en el clima”, y seguirá siendo verdad.

Ya que lo anterior es trivialmente cierto, las únicas preguntas interesantes son: 1) ¿Cuánto influye este o aquel organismo en el clima”, 2) ¿En qué medida esas influencias son buenas o nocivas?, y 3) ¿Puede los aspectos positivos ser magnificados y los nocivos mitigados?

Los climatólogos pasan la mayor parte de su tiempo con (1), la primera parte de (2) es generalmente ignorada, y los “activistas” hacen que su interés radique en la última parte de (3), ignorando también la primera parte. Pero nos estamos alejando de nuestra meta original. ¿Qué significan las temperaturas en descenso para la teoría CGA?

Examinemos la afirmación “la temperatura probablemente se elevará año a año”. ¿Cuáles observaciones, si es que las hay, son inconsistentes con esta aseveración? Ninguna. No hay ningún conjunto de circunstancias que pueda surgir y que directamente la contradigan. Las temperaturas pueden ascender y pueden descender, pueden descender cada año desde ahora hasta el año 3000 y la aseveración continúa sosteniéndose.

Falsabilidad

Esta es otra forma de establecer que la teoría CGA no es falsable. ¡Pero esperen! No quiero decir que esto es una debilidad de la teoría. Cualquier teoría que realice afirmaciones de probabilidad no puede ser falsada. Por lo tanto, es un error (y uno que observo a menudo) atacar a la teoría CGA porque no es falsable. ¡Por supuesto que no lo es! ¿Cuántas teorías son así, es decir, no falsables? Además de las proposiciones matemáticas, y no deseando llegar muy lejos con esto, todas las teorías que son de interés práctico para la humanidad. Cualquier teoría que se vea forzada a realizar afirmaciones probabilísticas no puede ser falsada. Y para ponerlo simplemente, esto incluye a la mayoría de las teorías con las que trabajamos en la vida real. Ya que este es el caso, debemos comprender lo que significa una aseveración probabilística, y que es lo que queremos significar con los datos “consistentes” o “inconsistentes” con tales aseveraciones.

Ahora bien, tenemos derecho a sospechar de una teoría que realiza una afirmación de que “X sucederá probablemente (en tales y tales circunstancias)” y de hecho X no ocurre. No habremos probado que la teoría es falsa, pero resultaría racional otorgar un mayor peso a la idea de que es falsa. Por lo tanto, no es irracional debilitar nuestra creencia en la teoría CGA frente al hecho de las temperaturas en descenso.

Más aún, el Dr. Stott está equivocado (no probablemente errado, o muy probablemente equivocado, sino totalmente equivocado) cuando responde “absolutamente no” a la pregunta “dado el descenso de la temperatura, ¿es menos probable que CGA sea verdadera? Pero estaría en lo correcto, exactamente en lo correcto, si contestara “absolutamente no” a la pregunta “dadas las temperaturas en descenso, ¿se ha probado que CGA es falsa? Viendo la manera en que informan los periódicos, no hay forma clara de saber a cual de estas dos preguntas estaba respondiendo el Dr. Stott.

Ya les había avisado que el asunto sería complicado. Ahora se pondrá peor, pero sigan conmigo.

¿Cuáles son las afirmaciones que se hacen?

Es muy difícil tener en mente las afirmaciones realizadas por una teoría compleja, razón por la cual cuando surge nueva evidencia, tenemos muchos discusiones diferentes sobre lo que implica esta evidencia. A causa de esto, los proponentes de las teorías controversiales están generalmente contentos por ser vagos sobre las afirmaciones que realizan. De esta forma, sin importar cuál sea la evidencia que surja, en ella podrán encontrarse argumentos a favor de la teoría. Hace unos días discutíamos esto mismo cuando hacíamos notar que las predicciones precisamente cuantificadas son difíciles de conseguir en el caso del calentamiento global.

Podríamos escuchar que “las temperaturas subirán”, pero esta es una afirmación vaga porque cuando las temperaturas descienden en un lugar en especial, el proponente puede decir “yo quería decir que subirían en otro lado”, o que “subirán en promedio”, o que “no dije que subirían siempre”.

Es por eso que los climatólogos de la universidad de Kiel pueden sostener que “la variación natural enmascararía el calentamiento de 0,3º predicho por el IPCC a lo largo de la próxima década” y que las temperaturas comenzarían a subir en 2015. Su declaración explicativa es imposiblemente vaga (decir que es “la variación natural” significa que se puede cuantificar exactamente el cambio causado por la existencia de la humanidad), pero al menos han realizado una predicción semi-cuantificable para dentro de seis años.

El IPCC también ha realizado predicciones cuantificables sobre las temperaturas globales promedio, aunque intentan introducir vaguedad al llamar “escenarios” a estas predicciones, un débil intento de evasión. Tampoco unen explícitamente la probabilidad a sus predicciones, lo que dificulta poder decir cuán correctas o incorrectas eran sus predicciones.

Para poder juzgar cuanto tenga probablemente de cierto una teoría se requieren predicciones explícitas. Por ejemplo, supongamos que la CGA hubiese realizado alguna de estas dos afirmaciones: A) “La temperatura global promedio probablemente aumentará, y B) “La temperatura global promedio posiblemente aumentará”. ¿Para cuál de estados dos afirmaciones, A o B, tendríamos menos certidumbre de que CGA es correcta?

¡Es una pregunta difícil! Intentemos comprenderla. Se puede ver que A y B difieren únicamente por las palabras “probablemente” y “posiblemente”. Supongamos que para nosotros “probablemente” significa “al menos un 90%”, y que “posiblemente” significa “al menos un 50%”.

Claramente, la afirmación B es más débil que la A. De modo que cuando surge evidencia contradictoria que la teoría que dio origen a A resulta más sospechosa que la teoría que originó B.

Los términos “probablemente”, “posiblemente”, “podría ser” y otros similares, no significan lo mismo para todas las personas. Por ejemplo, yo podría decir que “probablemente” significa “al menos 50%” y que “posiblemente” significa “al menos 90%”, de modo que llegaría a una conclusión completamente opuesta sobre la validez de la teoría en cuestión al que llegaron las otras personas.

Todo esto significa que cuanto más precisa es una predicción, más fácil resulta de juzgar, y que cuanto más vaga sea, más difícil será descartar o aceptar la teoría que la originó.

No todas las afirmaciones pueden ser cuantificadas con exactitud, pero cualquier predicción de importancia debe ser expresada claramente en términos de las decisiones o acciones que tendríamos que realizar si la afirmación fuera verdad. De modo que no es ninguna excusa el decir que “el problema es demasiado complicado como para ofrecer una predicción precisa”, porque si eso fuera verdad, entonces la teoría no tendría consecuencias prácticas, y por lo tanto podría ser ignorada. Para decirlo claramente, la teoría CGA afirma que tiene consecuencias prácticas, de modo que sus proponentes deberían poder ofrecernos predicciones más exactas.

Como dije antes, no siempre se tienen afirmaciones precisas en la CGA, aunque por supuesto a veces hay alguna, pero supongamos que la teoría afirma que “hay una probabilidad del 90% de que la temperatura global promedio aumentará año a año”. A lo largo de los últimos años las temperaturas han caído. La teoría no ha sido falsada porque la predicción únicamente mencionaba una probabilidad, una que es consistente con las temperaturas en descenso. Seremos razonables, sin embargo, si disminuye nuestra creencia en la verdad de la teoría.

Ahora supongamos que un grupo de climatólogos ofrece una teoría rival llamada “Negocios como siempre” (NCS) que realiza la predicción de que “hay un 50% de probabilidad de que aumente la temperatura global promedio”. Durante los últimos años la temperatura ha bajado. La teoría no ha sido falsada porque predice únicamente una probabilidad, una que es consistente con las temperaturas en descenso. Seremos razonables si, cuando nos ofrecen una elección entre las dos teorías, de aumentar nuestra creencia en la verdad de la teoría NCS sobre la teoría CGA porque las predicciones de la NCS estuvieron más cercanas a lo sucedido realmente. Las temperaturas cayeron, pero al decir que hay un 50% de probabilidad de que esto suceda cada año, estará más cerca de lo correcto que decir que hay únicamente un 10% de probabilidad de que esto suceda (10% = 100% - 90%).

La teoría mejor, que no está en oferta, es la que predijo que las temperaturas caerían durante los dos últimos años. Por lo tanto, ofreceré esa teoría (a la que llamaré “cariño, hace frío afuera” = CHFA) que afirma que “hay una probabilidad del 10% de que año a año aumente la temperatura global promedio”. Esta es la mejor de las tres teorías en el sentido de que sus predicciones probabilísticas estuvieron más cercanas a lo realmente acontecido. La teoría CHFA dice que hay una probabilidad del 90% (es decir 100% - 10%) de que las temperaturas caigan.

El asunto está una vez más a punto de complicarse. Asegúrese de haber comprendido toda hasta ahora, antes de seguir leyendo.

Pericia

No juzgamos a las teorías simplemente por lo bien que predicen datos futuros, sino también por la forma en que explican los datos observados. La teoría CHFA, como pueden ustedes suponer, no explica muy todos los datos previos. Los proponentes de la teoría CGA dicen que la suya sí lo hace. La teoría NCS realiza un trabajo razonable pero imperfecto cuando explica los datos históricos.

Ahora bien, que una teoría explique bien los datos del pasado no significa que explique bien los datos futuros. Esto es así porque siempre puede crearse una teoría que explique los datos pasados en forma perfecta, o casi tan cerca de la perfección como queramos estar. Esto hay que memorizarlo, especialmente si se lee cualquier artículo que utilice resultados estadísticos. Por lo tanto, dada una actuación razonable en la explicación de los datos históricos, la prueba real radica siempre en cuán bien predice datos que todavía no han sido observados (los que se definen como datos que no han sido utilizados de ninguna forma para crear la teoría).

Para ser realistas, el modelo CHFA está fuera de competencia por su rendimiento demasiado pobre sobre los datos históricos. Los dos competidores que quedan son CGA y NCS (no quiero implicar que estos son los dos únicos competidores en la vida real, sino que simplemente son los dos únicos que consideramos aquí). La competencia radica en cuán bien se comporta cada modelo para la predicción de datos futuros.

Hay algunos conceptos matemáticos que dicen que si tenemos dos o más teorías competidoras, la que está calibrada es mejor que la otra en el sentido de que cualquiera que actúe basado en información de la teoría calibrada lo haría mejor que quien actúe teniendo en cuenta la información de la otra teoría. Calibración significa que si una teoría dice “hay un Y% de posibilidad de que ocurra X”, y que por lo tanto un Y% de las veces podría ocurrir X, en efecto suceda así. Ni la teoría CGA ni la NCS están calibradas en este sentido.

Pero existe la impresión de que la teoría NCS es más simple que la teoría CGA. La teoría NCS no requiere grados avanzados para ser comprendida, y tampoco requiere enormes cantidades de computadores de muchos millones de dólares, ni necesita paneles de burócratas que se reúnen anualmente para discutirla. En cambio, la teoría CGA sí necesita todo ello; es una teoría sofisticada (no estoy utilizando esta palabra en forma sarcástica).

Podríamos esperar que, dados todo el tiempo, esfuerzo y dinero que se gasta en la sofisticada teoría CGA, pudiera vencer a la NCS en sus predicciones. Si no sucede así, si la teoría NCS vence rutinariamente a la teoría CGA, entonces sería racional darle más peso a la verdad de la teoría NCS.

Hasta ahora, al menos por todo lo que puedo ver, la teoría NCS sí supera a la teoría CGA en su capacidad de predicción. En realidad, es una modificación de la teoría NCS la que vence generalmente. Esa modificación dice algo así como “hay un 90% de posibilidad de que la temperatura global promedio se comporte como lo hizo el año pasado”. Esto es lo que técnicamente se conoce como persistencia (NCS(P) ).

Cuando una teoría sofisticada no puede superar ni a la teoría NCS ni a la NCS(P), se dice entonces que no tiene pericia. Si una teoría no tiene pericia, no debería ser utilizada, es decir, nadie debería basar sus decisiones basándose en esa teoría. Por lo que puedo ver, la teoría CGA no tiene pericia.

Mi única duda radica en “por lo que puedo ver”. Estoy limitado por la naturaleza inexacta de las predicciones de la teoría CGA. Ciertamente, las teorías NCS y NCS(P) son lo suficientemente precisas. Podría suceder, por ejemplo, que yo haya cuantificado mal las predicciones CGA, o que no haya comprendido exactamente cuáles son las variables físicas a las que se esta refiriendo, o que haya caracterizado erróneamente lo que implican las predicciones CGA. Por ejemplo, estoy considerando que dice que “hay una probabilidad de un 90% de que año a año aumente la temperatura global promedio”. Agradeceré cualquier corrección a mi caracterización. De hecho, todos agradeceríamos esa corrección y esperaríamos la publicación de declaraciones y predicciones precisas.

Entonces, ¿qué evidencian las temperaturas en descenso?

¿Qué sucede entonces? Ya que las temperaturas han caído, ¿qué debemos creer? No es verdad que la teoría CGA haya sido falsada, pero tampoco lo han sido las teorías NCS y NSC(P). Dada nuestra caracterización de la teoría CGA, es racional decir que nuestra creencia en ella, dadas las observaciones contradictorias, debería verse disminuida. Las teorías NCS permanecen tan ciertas como siempre, es decir, nuestras creencias en ellas no aumentan ni disminuyen, basándonos en esta nueva evidencia.

Podría ser, como ya he admitido, que nuestra caracterización de la afirmación de la teoría es equivocada. Otra caracterización fue ofrecida por el grupo de la universidad de Kiel, que posiblemente están sosteniendo que las temperaturas probablemente caerán o se mantendrán constantes hasta 2015, después de lo cual probablemente aumentarán. Digo “posiblemente” porque no queda claro cuál es su predicción exacta. Sin embargo, es posiblemente un buen resumen de ella.

Ahora bien, como las predicciones de “probablemente cayendo o permaneciendo constantes hasta 2015” son iguales a las predicciones realizadas por las teorías NCS y NCS(P), resulta obvio que la teoría de la universidad de Kiel y otras similares no tienen pericia. Es verdad que se podría decir que podrían tenerla, pero no lo sabremos hasta después del 2015.

Por mi parte, estaría contento de esperar hasta entonces para hacer algo.

Para anticipar la respuesta a esta conclusión, que discutiremos más ampliamente en alguna fecha posterior (queriendo decir no espero que esta contestación breve rebata plenamente a esa respuesta) de que si ustedes no han probado pericia, ¿porqué deberíamos hacer algo?, y si ustedes dicen que las consecuencias son demasiado horribles si no lo hacemos, preguntaría por qué también refutan el argumento de Pascal.

# # # # # # # # # # # # # # #

NOTAS Y COMENTARIOS

por Heber Rizzo

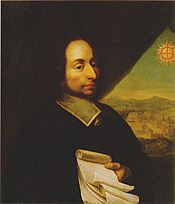

El argumento de Pascal al que se refiere el autor del artículo precedente, William M. Briggs, es una sugerencia del científico y filósofo francés Blaise Pascal. He aquí un poco más de información al respecto:

La Apuesta de Pascal): También llamada el Gambito o el Argumento de Pascal y publicada como la No. 233 de la recopilación de notas escrita durante los últimos años de vida del filósofo y publicada post-mortem con el título de “Pensées”, dice que aunque la razón no puede determinar la existencia o no de dios, una persona debería “apostar” a que ese dios existe, ya que viviendo y comportándose bajo esa suposición, tiene todo para ganar, y ciertamente nada para perder.

|

Blaise Pascal (1623-1662) © Wikipedia |

Para ser más exactos, la nota (aclaraciones agregadas) reza más o menos así: “Si se cree equivocadamente en Dios, no se pierde nada (asumiendo que la muerte es el fin absoluto”, mientras que si se cree correctamente en Dios, se gana todo (la felicidad eterna) . Pero si se descree correctamente en Dios, no se gana nada (con la muerte termina todo), mientras que si erróneamente se descree en Dios, se pierde todo (condenación eterna).

Esta sugerencia, por supuesto, ha tenido varias respuestas, tanto por ateos y escépticos como por teístas.

Por ejemplo, entre otras varias refutaciones, Theodore M. Drange dice: “Puede ser que dios no exista, y que en cambio otro ser gobierne el universo. Es ser puede molestarse enormemente e infligir un castigo infinito a quien crea en dios o que crea cualquier cosa por motivo de interés propio (como se recomiende en la Apuesta de Pascal). Por lo tanto, si una persona creyera en dios basada en esa premisa se encontraría con un montón de problemas, aún en el caso de que dios no existiera. La utilidad esperada en la situación del así creyente sería infinitamente peor que la del no creyente. Por lo tanto, la premisa es falsa”.

En su libro “El espejismo de dios”, Richard Dawkins sostiene su posición contraria de esta forma: “Supongamos que aceptamos que de hecho hay alguna pequeña posibilidad de que dios exista. De cualquier forma, se puede decir que se llevará una vida mejor y más completa si se apuesta sobre su no existencia, que si se apostara por ella y se dilapidara así un tiempo precioso en adorarlo, haciéndole sacrificios, luchando y muriendo por él, etc. ...Puedo decidir ir a la iglesia y recitar el Credo de Nicea, y puedo decidir jurar sobre un montón de biblias que creo cada palabra escrita en ellas. Pero nada de lo que haga puede hacerme creer sinceramente, si realmente no creo en él. La Apuesta de Pascal sería entonces únicamente un argumento para fingir que se cree en dios”.

Otros han argumentado también que, “habiendo más de 2 500 dioses cuya creencia está activa en la actualidad, ¿cómo saber cuál es el verdadero, y por lo tanto en cuál creer? Las posibilidades de acertar con el dios correcto, es decir, de estar en lo cierto, es de apenas 1 en 2 500, una muy mala apuesta, en realidad”.

Blaise Pascal: Matemático, físico y filósofo religioso francés, nacido en Clermont-Ferrand el 19 de junio de 1623 y fallecido en París el 19 de agosto de 1662. Fue un niño prodigio educado por su padre, un funcionario civil.

Sus trabajos iniciales fueron sobre la naturaleza y las ciencias aplicadas, donde realizó importantes contribuciones en la construcción de calculadoras mecánicas y en el estudio de los fluidos. Se lo considera el padre de las computadoras.

Clarificó los conceptos de presión y de vacío, popularizando el trabajo del italiano Evangelista Torricelli. Estudió la teoría matemática de la probabilidad, y fue también un defensor del método científico.

Una experiencia espiritual lo llevó a la filosofía y a comenzar a escribir una apología del cristianismo, llamada “Pensées” (“Pensamientos)”, de la cual solamente realizó una serie de notas y a la que nunca pudo terminar a causa de su temprana muerte, a los 39 años de edad.

# # # # # # # # # # # # # # #

= = = = = = = = = = = = = = =

Artículo original: “Just what are falling temperatures evidence of?”

Autor: William M. Briggs

Fecha: Diciembre 09, 2008

Enlace con el artículo original: aquíIMPORTANTE: El contenido de la sección “NOTAS Y COMENTARIOS” es de responsabilidad exclusiva de Heber Rizzo, y no forma parte del artículo original.= = = = = = = = = = = = = = =